안녕하세요 오늘은 개인 컴퓨터에서 AI를 구현하는법을 알려드릴게요

아 그리고 저번의 스크립트강의는 문제가생겨서 더이상 못하는점 죄송합니다

주의사항 : 본 글의 내용을 모두 읽어주신후 진행하시길 권장합니다

llamafile 다운로드

먼저 llamafile 이라는것을 다운로드받아주세요

https://github.com/Mozilla-Ocho/llamafile

| LLaVA 1.5 | 3.97 GB | LLaMA 2 | llava-v1.5-7b-q4.llamafile |

| Mistral-7B-Instruct | 5.15 GB | Apache 2.0 | mistral-7b-instruct-v0.2.Q5_K_M.llamafile |

| Mixtral-8x7B-Instruct | 30.03 GB | Apache 2.0 | mixtral-8x7b-instruct-v0.1.Q5_K_M.llamafile |

| WizardCoder-Python-34B | 22.23 GB | LLaMA 2 | wizardcoder-python-34b-v1.0.Q5_K_M.llamafile |

| WizardCoder-Python-13B | 7.33 GB | LLaMA 2 | wizardcoder-python-13b.llamafile |

| TinyLlama-1.1B | 0.76 GB | Apache 2.0 | TinyLlama-1.1B-Chat-v1.0.Q5_K_M.llamafile |

| Rocket-3B | 1.89 GB | cc-by-sa-4.0 | rocket-3b.Q5_K_M.llamafile |

| Phi-2 | 1.96 GB | MIT | phi-2.Q5_K_M.llamafile |

위 링크또는 위 표에서 원하시는 파일을 다운로드받아주세요

| 이름 | 사양 |

| LLaVA 1.5 | 일반적인 사양 |

| Mistral-7B-Instruct | 일반적인 사양 |

| Mixtral-8x7B-Instruct | 고사양 요구 |

| WizardCoder-Python-34B | 고사양 요구 |

| WizardCoder-Python-13B | 약간 고사양 |

| TinyLlama-1.1B | 저사양 |

| Rocket-3B | 저사양 |

| Phi-2 | 저사양 |

물론 성능이 가장 뛰어난 Mixtral-8x7B-Instruct를 사용하셔도 무방합니다

주의사항 : 일반적인 windows 환경에서는 4GB가 넘는 실행파일은 실행하지 못합니다 따라서 windows에서는 (LLaVA 1.5 , TinyLlama-1.1B , Rocket-3B , Phi-2)파일만 실행이 가능합니다 따라서 Linux 또는 Mac 환경에서 실행을 하시는것을 강력히 권장드립니다 본 강의에서는 Linux Mint Cinnamon Edition을 이용해서 실습을 진행합니다.

또한 컴퓨터의 RAM 용량보다 큰 파일은 실행하지 못하니 컴퓨터의 RAM 용량을 확인부탁드립니다 권장RAM 용량은 32GB 이상입니다

실행하기(Linux and Mac)

다운로드를 마치셨다면 실행을 할시간입니다

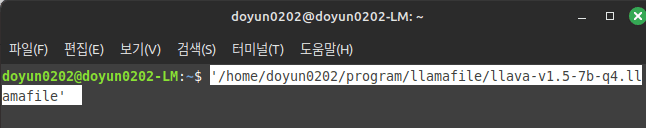

본 강의에서는 Linux Mint Cinnamon Edition으로 LLaVA 1.5를 실행해보겠습니다

다운로드한 실행파일을 터미널에 드래그 & 드롭합니다 그 이후

위와 비슷하게 경로가 자동으로 입력되셨다면 Enter를 눌러서 실행합니다

만약 아레와 비슷한 실행오류가 발생할경우

bash: /home/doyun0202/program/llamafile/llava-v1.5-7b-q4.llamafile: 허가 거부chmod 755 < 파일명 >을 입력하시고 다시 실행해보시길 바랍니다 < 파일명 > 에는 아까와 같은 방식으로 파일경로를 입력해주세요

실행하기(windows)

windows 환경에서 실행하려면 더욱더 간단합니다 파일을 다운로드받은후 확장자에 .exe만 추가해주시면 됩니다!

사용하기

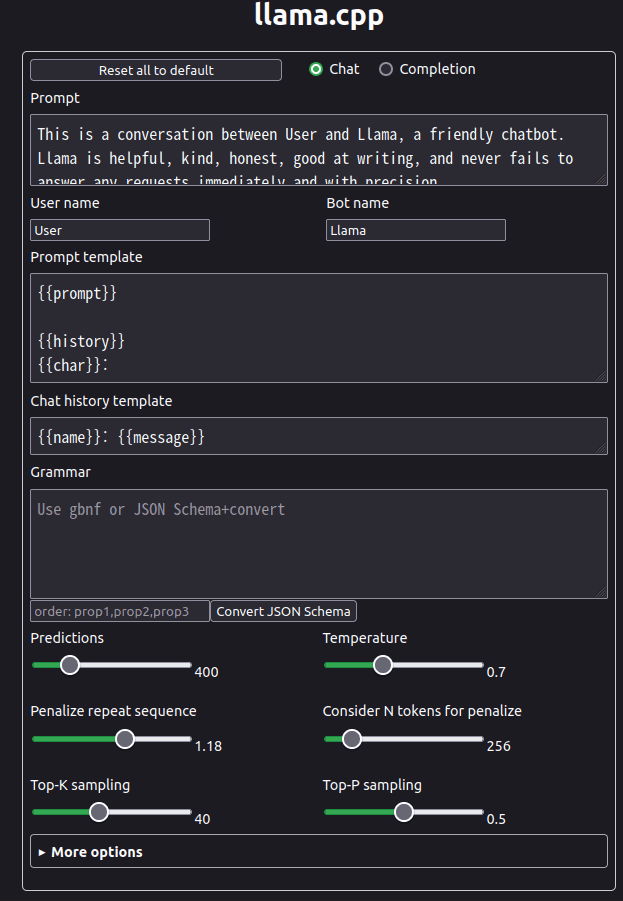

이제 조금만 기다려보시면 인터넷창이 하나 나올것입니다

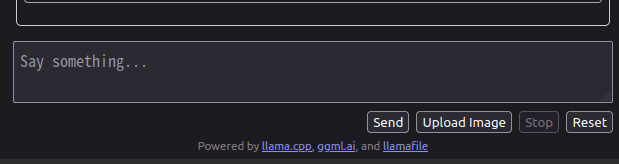

위 창이 나온다면 아레의 Say something… 에 원하시는 내용을 적어주세요 영어를 권장합니다 사용법은 chat gpt랑 비슷합니다

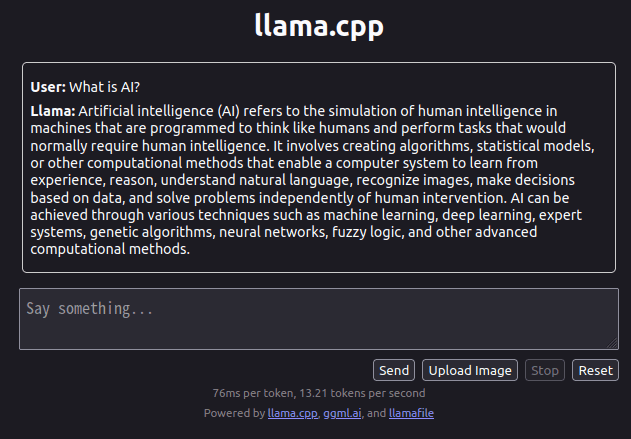

저는 AI가 무엇인지 물어보니 성실하게 답변을 해주네요

해석 : 인공지능(AI)은 인간처럼 생각하고 일반적으로 인간의 지능이 필요한 작업을 수행하도록 프로그래밍된 기계에서 인간 지능을 시뮬레이션하는 것을 말합니다. 여기에는 컴퓨터 시스템이 경험, 추론을 통해 학습하고, 자연어를 이해하고, 이미지를 인식하고, 데이터를 기반으로 결정을 내리고, 인간의 개입과 독립적으로 문제를 해결할 수 있도록 하는 알고리즘, 통계 모델 또는 기타 계산 방법을 만드는 것이 포함됩니다. AI는 머신러닝, 딥러닝, 전문가 시스템, 유전자 알고리즘, 신경망, 퍼지 논리 및 기타 고급 계산 방법과 같은 다양한 기술을 통해 달성될 수 있습니다.

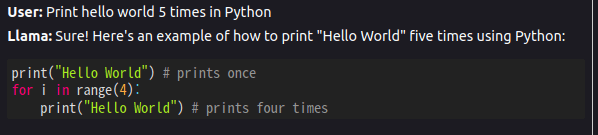

한번 파이썬으로 Hello world를 5번 출력하게 해볼까요?

정말로 만들어주네요 다만 아직 아쉬운부분은 for문 5번 실행해서 출력하는것이 아닌 그냥출력 한번하고 나머지 4번을 for문으로 한다는것은 좀 아쉬운점이네요

참고로 저의 컴퓨터 사양은 이렇습니다

CPU : i7-14700k

RAM : 삼성 DDR5-5600 32GB * 2

MainBoard : Z790 aorus elite ax ice

GPU : RTX 4060

하지만 기본상태에서 작동해보니 GPU보다는 CPU를 더 사용하더라고요

그부분은 조금 아쉽지만 그래도 재미있는 오픈소스 프로젝트인것 같습니다

저는 이제 이만 물러나보겠습니다 읽어주셔서 감사합니다!

후원하기 : https://toss.me/doyun0202

Equili

폰테크

сглобяеми къщи

New York weed clone delivery

dolly4d login

Hanging jackets or backpacks becomes smoother with a reliable hook. https://thepruite.com/ hooks never wobble under weight. I appreciate how simple it makes everyday organization. Each corner feels a little sharper and calmer because of them.

???????????????????!https://lantu-jp.com/??????????????????????????????????????????????????????????????????????????????????????????????????????LANTU????????????????????

“???????????????????????????! https://kandao-jp.com/

?KanDao?????????????????????????????????????????360°????????????????????AI???????????????????????????KanDao?????????????”

?????????????????????????!https://xgaghb-jp.com/??????????????????????????????????????MP3??????????????????????????????????????????????????????????XGAGHB????????????????????????

Hanging jackets or backpacks becomes smoother with a reliable hook. https://thepruite.com/ hooks never wobble under weight. I appreciate how simple it makes everyday organization. Each corner feels a little sharper and calmer because of them.

Willkommen beihttps://das-accakappa.de/ Virginia Rose. Die Kollektion umfasst Eau de Cologne, die leicht auf Haut und Kleidung liegt. Der Duft offnet mit floralen Noten, weich und klar, bleibt subtil uber Stunden. Acca Kappa Virginia Rose ist in 100 ml Flakons erhaltlich, einfach in der Anwendung, angenehm zu tragen und fur Damen gedacht, die florale Eleganz mogen.

Hallo! https://das-sparkfun.de/ zeigt, wie MicroPython- und RedBoard-Kits Technik greifbar machen. Sensoren messen Licht, Abstand und Bewegung, OLED-Displays geben Daten aus, Motoren und Servos setzen Signale in Bewegung um. Tasten, Potentiometer und Kabel erleichtern Experimente, alles passt auf das Steckboard, ohne Loten. Fur Maker, Schuler oder Hobbyisten sind die Kits ubersichtlich aufgebaut, Schritt-fur-Schritt-Projekte fuhren durch verschiedene Schaltungen und zeigen direkt, wie Sensoren, Motoren und Displays zusammenarbeiten. Zubehor wie USB-C-Kabel oder Qwiic-Module erweitern Moglichkeiten weiter.

Hallo, Freunde von Ordnung und Ideen! https://banborba.de/ steht fur Dinge, die funktionieren – stark, durchdacht, zuverlassig. Von Edelstahl-Tischen und Gasherden uber Wasserhahne, Steamer und Weinstander bis hin zu Dartboards oder Baumkletter-Sets. Hier zahlt jedes Detail, jedes Material, jede Schraube. Es ist das kleine Gluck, wenn alles seinen Platz hat und alles halt, was es verspricht. banborba – wo Alltag nicht kompliziert, sondern einfach gut gemacht ist.

Hallo an alle, die den Duft junger Blatter lieben. Mit https://das-viparspectra.de/ erwacht jedes Pflanzchen zum Leben, sanft gefuhrt vom prazisen Spiel aus Licht und Schatten. Ob winziger Spross oder kraftige Blute – die Lampen schaffen ein Klima, das nahrt, starkt und wachsen lasst. Technik und Natur tanzen hier in leuchtender Harmonie.

Hallo an alle, die gerne Neues entdecken. Bei https://sumeber.de/ treffen Bewegung und Alltag aufeinander – hier rollen Kinder auf leuchtenden Inlinern durch den Park, gleiten Jugendliche auf Waveboards durch die Stra?en, wahrend daheim Wasserhahne glanzen, Tische funkeln und Schirme Regen in Kunst verwandeln. Jedes Stuck bringt ein Stuck Freude in den Tag – leicht, clever, lebendig.

Hallo an alle, die Taschen lieben. Bei https://bestou.de/ glitzert jede Form ein bisschen anders – mal mit funkelnder Geometrie, mal mit ruhiger Lederoptik. Gro?e Shopper, zarte Clutches, wandelbare Umhangetaschen – sie alle halten kleine Welten zusammen. Fur Arbeit, Spaziergang oder Abendlicht, jede begleitet den Tag mit Glanz und Gefuhl.

“???????????????????????????!https://michealwu-jp.com/

?MICHEALWU?????????????????????????????????????????????????????????????????????????????????????????????????????MICHEALWU?????????????”

Hey everyone! If you’re planning an outdoor adventure, check out https://mycamelcrown.com/. You’ll find comfy, durable gear like hiking shoes, jackets, and even camping tents. They blend style with functionality, so you can stay comfy and look good while exploring. Definitely worth a look if you love the outdoors!

Hey! Hier geht es um mehr als nur Farbe – https://das-bondex.de/ schutzt, nahrt und lasst Holz atmen. Ob wetterfeste Lasuren, seidig glanzende Lacke oder tief pflegende Ole, jede Formel ist gemacht, um Regen, Sonne und Zeit zu trotzen. Fur Zaune, Terrassen, Gartenhauser, fur alles, was drau?en steht und Charakter hat. Bondex halt, was Natur verspricht – Bestandigkeit mit Herz und Hand.

Hallo bei https://das-bosca.de/. Die Auswahl reicht von elektrischen Fondues uber Raclette-Sets bis zu Pizza- und Schneidewerkzeugen. Fondue- und Raclette-Topfe sitzen stabil auf dem Tisch, die Messer schneiden Kase und Fleisch prazise, Boards tragen Snacks oder Tapas. Grillplatten, Pizzaheber und Pizzasteine erweitern die Moglichkeiten, alles aus robustem Holz und Edelstahl, einfach zu handhaben, direkt auf dem Tisch einsetzbar. Jede Komponente fuhlt sich vertraut an und erleichtert das gemeinsame Essen.

Lock and Love creates jewelry inspired by love and connection, perfect for special moments. Their designs include locks, keys, and heart motifs to symbolize affection. Discover their collection at https://thelockandlove.com.

Aablexema’s accessories and fashion items stand out for their originality and quality. Perfect for those who want to add personality to their look. Check out their offerings at https://theaablexema.com.

Moonet’s collection focuses on casual pieces with clean lines and comfortable fabrics. Ideal for those who appreciate simple, versatile style. Discover the range at https://themoonet.com.

Hallo an alle, die den Geruch von Farbe und den Klang klickender Teile lieben. https://das-aoshima.de/ erschafft kleine Wunder aus Plastik – vom kultigen Knight Rider bis zum legendaren DeLorean. Turen offnen sich, Lichter glimmen, Formen erwachen. Jedes Modell erzahlt Geschichten von Geschwindigkeit, Kino und Kindheit, eingefangen im Ma?stab 1:24.

Hallo bei https://dasdasique.de/. Die Palette vereint verschiedene Rouge- und Puderfarben, die sich leicht auftragen lassen. Lippenbalsame in Beerentonen oder sanften Pfirsichnuancen geben Feuchtigkeit und Glanz. Concealer-Paletten gleichen Hauttone aus und decken punktuelle Unregelma?igkeiten ab. Alle Produkte gleiten sanft, lassen sich mischen und wirken naturlich, vegan hergestellt, fur unkomplizierte Anwendung jeden Tag.

Hallo! Bei https://das-aulos.de/ zeigt sich, wie Sopran- und Altblockfloten klingen und sich greifen lassen. Jede Flote fuhlt sich solide an, die Tone sind gleichma?ig und klar. Die Instrumente gleiten angenehm durch die Finger, lassen sich einfach stimmen und reinigen. Spieler erleben direkt, wie sich Musik muhelos formen lasst.

Hallo! Bei https://das-uking.de/ stehen LED Moving Heads bereit, die RGBW-Farben mischen und sich flexibel ausrichten lassen. Nebelmaschinen erzeugen dichte, sichtbare Effekte, die das Licht sichtbar machen. LED Bars, Wall Washer und Schwarzlicht erganzen die Ausstattung. Die Gerate lassen sich einfach bedienen, reagieren auf Musik und bringen Buhnen, Partys oder Clubabende lebendig zum Leuchten.

pg slot

แพลตฟอร์ม TKBNEKO เป็นแพลตฟอร์มเกมออนไลน์ ที่ ออกแบบโครงสร้างโดยยึดพฤติกรรมผู้ใช้เป็นศูนย์กลาง. หน้าแรก ประกาศตัวเลขชัดเจนทันที: ขั้นต่ำฝาก 1 บาท, ถอนขั้นต่ำ 1 บาท, เวลาฝากประมาณ 3 วินาที, และ ไม่จำกัดยอดถอน. ตัวเลขเหล่านี้กำหนดภาระของระบบโดยตรง เพราะเมื่อ กำหนดขั้นต่ำต่ำ ระบบต้อง รับรายการฝากถอนจำนวนมากที่มียอดเล็ก และต้อง ประมวลผลแบบเรียลไทม์. หาก การยืนยันเครดิตใช้เวลานานเกินไม่กี่วินาที ผู้ใช้จะ กดซ้ำ ทำให้เกิด รายการซ้อน และ เพิ่มโหลดฝั่งเซิร์ฟเวอร์ทันที.

การเติมเงินด้วยการสแกน QR ตัดขั้นตอนการกรอกข้อมูลและการแนบสลิป. เมื่อผู้ใช้ สแกนคิวอาร์ ระบบจะรับสถานะธุรกรรมจากธนาคารผ่าน API. จากนั้น backend จะ ผูกธุรกรรมเข้ากับบัญชีผู้ใช้ และ เติมเครดิตเข้า wallet. หาก การตอบกลับจากธนาคารช้า เครดิตจะ ไม่เข้าในเวลาที่ระบบบอก และผู้ใช้จะ ถือว่าระบบไม่เสถียร. ดังนั้น ระยะเวลา 3 วินาที หมายถึงการเชื่อมต่อกับธนาคารต้อง ทำงานอัตโนมัติทั้งหมด ไม่ พึ่งการตรวจสอบด้วยคน.

การรองรับหลายธนาคาร เช่น KBank, ธนาคารกรุงเทพ, KTB, กรุงศรี, Siam Commercial Bank, ซีไอเอ็มบี ไทย รวมถึง ทรูมันนี่ วอลเล็ท ทำให้ระบบต้อง รับ callback หลายต้นทาง. แต่ละธนาคารมีรูปแบบข้อมูลและเวลาตอบสนองต่างกัน. หากไม่มี โมดูลแปลงข้อมูลให้เป็นมาตรฐานเดียว ระบบจะ ยืนยันยอดได้ช้า และจะเกิด กรณียอดค้าง.

หมวดเกม ถูกแยกเป็น สล็อตออนไลน์, เกมสด, กีฬา และ เกมยิงปลา. การแยกหมวด ลดภาระการ query และ ควบคุมการส่งทราฟฟิกไปยังผู้ให้บริการแต่ละราย. สล็อต มัก ทำงานผ่าน session API ส่วน คาสิโนสด ใช้ สตรีมภาพแบบเรียลไทม์. หาก session หลุด ผู้เล่นจะ หลุดจากโต๊ะทันที. ดังนั้นระบบต้องมี ตัวจัดการ session ที่ คุมการเชื่อมต่อ และ ซิงค์เครดิตกับ provider ตลอด. หาก ซิงค์พลาด เครดิตผู้เล่นกับผลเกมจะ ไม่ตรงกัน.

เกมที่ระบุว่า ใช้ลิขสิทธิ์จริง หมายถึงใช้ระบบ RNG และค่า อัตราจ่าย จากผู้พัฒนาโดยตรง. ผลลัพธ์แต่ละรอบถูก คำนวณจากฝั่ง provider ไม่ใช่จากฝั่งเว็บ. หากไม่มี ลิงก์ไปยังเซิร์ฟเวอร์ต้นทาง เว็บจะ รับผลเกมจริงไม่ได้ และ สิทธิ์ใช้งานจะถูกตัด. การมี ใบรับรอง จึง ผูกกับโครงสร้างการส่งข้อมูล ไม่ใช่ แค่คำบนหน้าเว็บ.

ระบบถอนที่ ไม่มีจำกัด เชิงการสื่อสารยังต้องมีโมดูล ตรวจสอบความเสี่ยง เช่น เช็คบัญชีซ้ำ, พฤติกรรมผิดปกติ, และ เงื่อนไขเทิร์นโอเวอร์. หากไม่มีการตรวจสอบเหล่านี้ ผู้ใช้สามารถ สร้างบัญชีหลายบัญชี เพื่อ เอาโบนัส และ ดึงสภาพคล่องออกจากระบบได้รวดเร็ว.

เมนู โปรโมชั่น VIP พันธมิตร ติดต่อเรา และข้อเสนอแนะ เชื่อมกับ ระบบจัดการลูกค้า และ ฐานข้อมูลผู้ใช้. ส่วน พันธมิตร ใช้เก็บ โค้ดอ้างอิง เพื่อ คำนวณค่าคอมมิชชั่น. หากไม่มีระบบนี้ จะ track ที่มาผู้ใช้ไม่ได้. ฟอร์มข้อเสนอแนะ ใช้เก็บ ข้อผิดพลาดจริงจากผู้ใช้. หากไม่มีข้อมูลนี้ ปัญหา latency หรือ UX จะ แก้ไม่ทัน.

โครงสร้างทั้งหมด เชื่อมกันเป็นสายเดียว: ธนาคารส่งสถานะเข้า backend, backend อัปเดต wallet แล้ว ซิงค์ไปยัง provider. หากส่วนใดส่วนหนึ่ง ช้า ผู้ใช้จะเห็นผลทันทีในรูปแบบ เครดิตไม่เข้า, เกมค้าง หรือ ถอนล่าช้า. ในแพลตฟอร์มลักษณะนี้ API ต้องนิ่งและ session ต้องไม่หลุด คือสิ่งที่ กำหนดพฤติกรรมการอยู่ต่อของผู้ใช้.

Ejercicio deportivo

Hallo! Bei https://das-primeline.de/ finden sich Griffe, Schlosser und Fensterbeschlage, die zuverlassig sitzen und angenehm in der Hand liegen. Die Mechanik lauft sauber, Turen und Fenster offnen sich leicht. Jedes Bauteil fuhlt sich stabil an, die Oberflache glatt und wertig. Ersatzteile und Rollen fur Schiebeturen erganzen das Sortiment. Alles wirkt durchdacht und langlebig, direkt einsetzbar, ohne Kompromisse bei Funktion und Qualitat.

Hallo! https://das-jmgo.de/ bringt Projektoren, die zu Hause oder drau?en genutzt werden konnen. Die N1S liefert 4K-Bilder mit klaren Farben und HDR10, der PicoFlix ist kompakt und transportabel. Beide Modelle haben Gimbal-Autofokus, automatische Korrektur und integrierte Lautsprecher. Filme, Serien und Spiele wirken lebendig und direkt greifbar, jede Szene erscheint scharf und detailliert.

Some days demand moving fast between tasks and relaxation. https://getruxury.com/ folding desk folds away neatly when I’m done. The surface is just the right size for my laptop and notes. It quietly makes transitions in the day feel natural.

Hallo! Bei https://diegodallapalma.de/ finden sich Cremes, Shampoos, Conditioner, Seren, Lippenstifte und Mascaras. Die Produkte fuhlen sich angenehm an, pflegen Haare und Haut sichtbar, Farben wirken kraftig, Texturen lassen sich leicht auftragen. Ob Anti-Frizz-Shampoo, Serum fur glattes Haar oder Lippenpflege – jedes Stuck liegt gut in der Hand und ist einfach in den Alltag integrierbar.

There’s something about aged patterns that slows me down. https://feasrt.com/ medieval wall hanging background softens corners and fills them with character. It doesn’t shout, but it sets the scene quietly. I find myself lingering longer just to take it in.

Hallo! https://miioto.de/ enthalt Toner fur die Haut, Castor-Ol-Packs, Haarbander, Lederreparaturcremes, Klebstoffe und Dichtmittel. Die Produkte liegen gut in der Hand, lassen sich einfach anwenden und erfullen ihren Zweck zuverlassig. Ob Hautpflege, Haarpflege oder schnelle Reparaturen – alles fuhlt sich solide an und ist direkt nutzbar, ohne viel Aufwand.

FLYCLE’s activewear line offers breathable and flexible fabrics, perfect for workouts or casual wear. Their modern designs combine function with fashion. Shop the collection at https://theflycle.com.